¶ Quantencomputer

¶ Wie Funktioniert ein Quantencomputer

¶ Was ist ein Quantencomputer

Ein Quantencomputer ist ein Computer, der die Gesetze der Quantenmechanik nutzt. Im Unterschied zum klassischen Computer arbeitet er nicht auf der Basis makroskopischer Zustände elektronischer Schaltkreise (alsao 1 oder 0), sondern quantenmechanischer Zustände geeigneter Systeme. Damit ist es möglich, im Laufe der Rechnung Superpositionszustände und Quantenverschränkung zu erzeugen, die beide für die Informationsverarbeitung in Quantencomputern entscheidend sind.

¶ Wie rechnen Quantencomputer (vereinfacht)

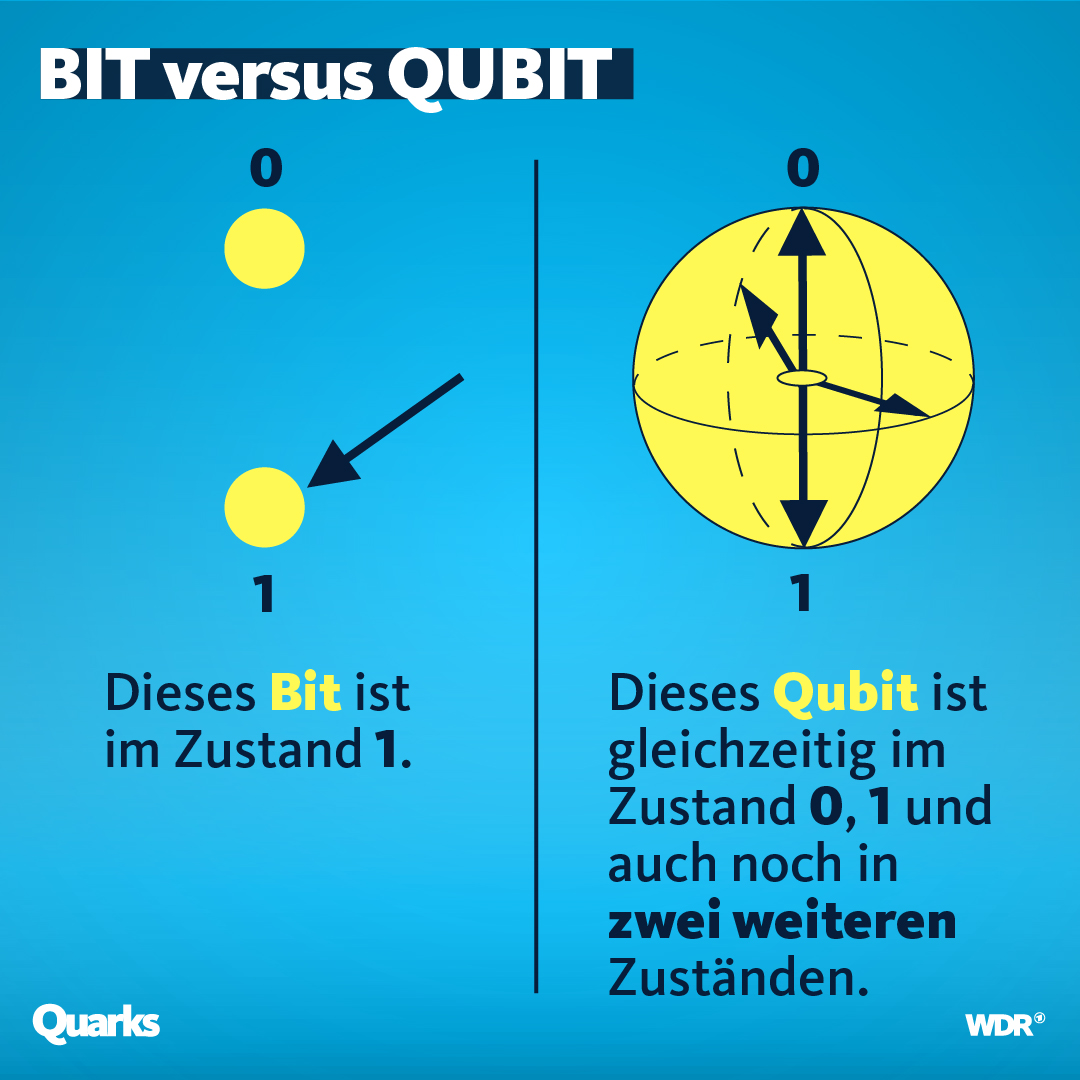

Um das Rechnen mit Quantencomputer zu verstehen, muss man erstmal verstehen was QuBits sind.

Herrkömmliche Computer rechnen mit Bits, sie haben einen festen Zustand, entweder 1 oder 0.

Ein Qubit jedoch kann zwei oder laut manchen Theorien sogar unendlich viele Zustände gleichzeitig haben.

Diesen Zustand nennt man Superposition.

Vereinfachte Darstellung von QuBits:

¶ Weitere Vorteile:

¶ Quantenverschränkung

Ein Weiteren Vorteil gibt die Quantenverschränkung. Die Quantenverschränkung "verbindet" im Prinzip die beiden Teilchen miteinander und somit werden alle Befehle die an das Teilchen gesendet werden an die jeweils mit dem Teilchen Verschränken Teilchen genauso ausgeführt.

¶ Quantenalgotithmen

Quantenalgorithmen könnten die Berechnungszeit für viele mathematische und physikalische Problemstellungen deutlich verringern. Beispielsweise zeigen theoretische Studien, dass Quantenalgorithmen bestimmte Probleme der Informatik, z. B. die Suche in extrem großen Datenbanken (siehe Grover-Algorithmus) und die Faktorisierung großer Zahlen (siehe Shor-Algorithmus) effizienter lösen können als klassische Algorithmen.

¶ Kurze geschichtliche Einordnung

Geprägt wurde der Begriff auf der ersten Conference on the Physics of Computation am MIT im Mai 1981 durch die Vorträge der Physiker Paul Benioff und Richard Feynman über quantum computing. Benioff präsentierte seine Arbeit, die zeigte, dass Computer unter den Gesetzen der Quantenmechanik arbeiten können. Feynmans Vortrag stellte erstmals ein Grundmodell für einen Quantencomputer vor.

Der Quantencomputer blieb lange ein überwiegend theoretisches Konzept. Es gab verschiedene Vorschläge, wie ein Quantencomputer realisiert werden könnte, in kleinem Maßstab wurden einige dieser Konzepte im Labor erprobt und Quantencomputer mit wenigen Qubits realisiert. Der Rekord lag im November 2021 bei 127 Qubits für den Prozessor und ein Jahr später bei 433 Qubits. Neben der Anzahl der Qubits ist aber auch zum Beispiel eine geringe Fehlerquote beim Rechnen und Auslesen wichtig und wie lange die Zustände in den Qubits fehlerfrei aufrechterhalten werden können.

Seit 2018 investieren viele Regierungen und Forschungsorganisationen sowie große Computer- und Technologiefirmen auf der ganzen Welt in die Entwicklung von Quantencomputern, die von vielen als eine der entstehenden Schlüsseltechnologien des 21. Jahrhunderts angesehen werden.